كيف يعمل ChatGPT؟ – العملة الرقمية

يمكن اعتبار الذكاء الاصطناعي بلا شك الموضوع الأكثر شيوعًا في عام 2023. ومن بين جميع منتجات الذكاء الاصطناعي ، تحظى ChatGPT بشعبية كبيرة.

نعلم جميعًا أن ChatGPT قدرتها على فهم النصوص المتقدمة وتقديم إجابات صحيحة ودقيقة. ومع ذلك ، قلة من الناس يعرفون كيف يتم إنشاء هذا الذكاء الاصطناعي الشهير ومن ثم يعمل.

ChatGPT عبارة عن روبوت محادثة يستخدم تقنية الذكاء الاصطناعي ويسمح لنا بتجربة محادثات مشابهة للمحادثات اليومية مع هذا الروبوت. يمكن أن يجيب نموذج اللغة الخاص بـ ChatGPT على العديد من الأسئلة ويساعدنا في القيام بأشياء مثل كتابة رسائل البريد الإلكتروني أو المقالات أو حتى الترميز.

لكن السؤال هو ، كيف تمكنت ChatGPT من فهم الأسئلة وتقديم إجابات دقيقة؟ في الآونة الأخيرة ، قام مؤلف في نحو علم البيانات بفحص هذه المسألة بالتفصيل نتائج شارك في هذه المقالة ، نشارك ترجمة هذه النتائج معك.

الإجابات الدقيقة والصحيحة لـ ChatGPT هي نتيجة استخدام التقنيات المتقدمة وسنوات من البحث. يمكن أن تكون التكنولوجيا وكيفية عمل ChatGPT معقدة ؛ لهذا السبب ، نحاول في هذه المقالة التحقق من تفاصيل برنامج الدردشة هذا بطريقة بسيطة.

لهذا الغرض ، نقدم أولاً نماذج لغوية كبيرة. بعد ذلك ، نحدد آلية تدريب GPT-3 وأخيراً نفحص التعلم من خلال ردود الفعل البشرية التي أدت إلى الأداء الرائع لـ ChatGPT. لمعرفة المزيد حول ChatGPT ، ابق معنا حتى نهاية المقال.

التعرف على نموذج اللغة الكبير

يعد نموذج اللغة الكبيرة (LLM) أحد نماذج التدريب على التعلم الآلي والذكاء الاصطناعي التي تم إنشاؤها لتفسير اللغة البشرية. تعمل LLM كقاعدة بيانات ضخمة ونوع من البنية التحتية التكنولوجية التي يمكنها معالجة كميات كبيرة من البيانات النصية.

اليوم ، مع تقدم التكنولوجيا وقوة الحوسبة ، أصبحت كفاءة LLM أعلى بكثير مما كانت عليه في الماضي ؛ لأنه مع زيادة مجموعة بيانات الإدخال ومساحة المعلمة ، تزداد أيضًا إمكانيات ووظائف LLM.

تتمثل طريقة التدريب القياسية لـ LLM في التنبؤ بالكلمة التالية في سلسلة من الكلمات باستخدام نموذج ذاكرة طويل المدى (LSTM). يمكن أن يعمل LSTM مع البيانات المتسلسلة مثل النص والصوت.

في طريقة التدريس هذه ، يجب على LLM التحقق من العبارات والكلمات قبل وبعد ، وبناءً على نتائج هذا الفحص ، قم بملء المساحة الفارغة من العبارة بالكلمة الأكثر ملاءمة. تتكرر هذه العملية عدة مرات حتى يتمكن النموذج من توليد إجابات دقيقة.

تتم العملية المذكورة في شكل توقع الرمز التالي (NTP) والنموذج اللغوي المقنع (MLM). في كلا النموذجين ، يجب أن يختار الذكاء الاصطناعي أفضل كلمة لملء الفراغ ؛ لكن موقع الوظيفة الشاغرة مختلف.

حدود التدريب مع LSTM

التدريب مع LSTM له أيضًا قيود. ضع في اعتبارك هذا المثال:

علي … قراءة الدروس (متحمس / معارض)

إذا طُلب منك ملء الفراغ بالكلمة الصحيحة ، يجب أن تعرف أولاً عن “علي” ؛ لأن اهتمامات الناس مختلفة. لذا ، إذا كنت تعلم أن علي مهتم بالدراسة ، فستختار “متحمس”.

ومع ذلك ، لا يمكن للنموذج تقييم الكلمات بشكل صحيح ودقيق ؛ لذلك قد يرى أهمية “الدراسة” أكثر من “علي” في هذه العبارة. لذلك ، مع الأخذ في الاعتبار أن الكثير من الناس يكرهون الدراسة وأداء الواجبات المنزلية ، يختار النموذج كلمة “معارض”.

أيضًا ، في هذا النموذج ، تتم معالجة بيانات الإدخال بشكل فردي ومتسلسل بدلاً من مجموعة كاملة ؛ لذلك ، في LSTM ، يكون فهم ومعالجة تعقيد العلاقات بين الكلمات والمعاني محدودًا.

نموذج المحولات

استجابة لهذه المشكلة ، في عام 2017 ، قدم فريق من Google Brain نموذجًا يسمى نموذج المحولات. على عكس LSTM ، يمكن للمحولات معالجة جميع بيانات الإدخال في وقت واحد.

تستخدم المحولات أيضًا آلية تسمى الاهتمام الذاتي. تقيس آلية الوعي الذاتي أهمية مكونات مجموعة البيانات من أجل الحصول على انطباع أكثر دقة عن المجموعة بأكملها.

لذلك ، بمساعدة هذه الآلية ، يمكن للمحولات فحص المكونات المختلفة للجملة والعبارة بشكل أكثر دقة وفهم علاقتها. تمكّن هذه الميزة المحولات من فهم مجموعات البيانات بشكل أفضل ومعالجة مجموعات بيانات أكبر بكثير.

آلية الاهتمام الذاتي في GPT

قامت شركة OpenAI بتطوير ChatGPT. إن ChatGPT ليس النموذج الوحيد للذكاء الاصطناعي و chatbot لهذه الشركة ؛ لأنه منذ عام 2018 ، طورت الشركة نماذج أولية تسمى نماذج Producer Pre-Trained Transformer (GPT).

تم تسمية النموذج الأول باسم GPT-1 ، وتم إصدار إصداراته المحسنة التالية في 2019 و 2020 بأسماء GPT-2 و GPT-3. في الآونة الأخيرة وفي عام 2022 ، شهدنا الكشف عن أحدث موديلاتها ، وهي InstructGPT و ChatGPT.

في حين أن التغيير من GPT-1 إلى GPT-2 لم يكن قفزة تكنولوجية كبيرة ، فقد شهد GPT-3 تغييرات كبيرة. مكنت التحسينات في الكفاءة الحسابية GPT-3 من التدرب على بيانات أكثر بكثير من GPT-2 ولديها قاعدة معرفية أكثر تنوعًا. لذلك ، في الإصدار الثالث ، كانت GPT قادرة على أداء مهام مختلفة.

تستخدم جميع طرز GPT بنية محول ولديها مشفر لمعالجة تسلسل بيانات الإدخال ووحدة فك ترميز لإنتاج بيانات تسلسل الإخراج.

يستخدم كل من جهاز التشفير وفك التشفير آلية الانتباه الذاتي متعددة الرؤوس التي تسمح للنموذج بفحص وتحليل أجزاء مختلفة من التسلسل. للقيام بذلك ، تقوم آلية الانتباه الذاتي بتحويل الرموز المميزة (أجزاء من النص يمكن أن تتضمن جملًا أو كلمات أو مجموعات نصية أخرى) إلى متجهات تُظهر أهمية الرمز المميز في العبارة.

يستخدم برنامج التشفير أيضًا نمذجة اللغة المقنعة لفهم العلاقة بين الكلمات وتقديم إجابات أفضل. بالإضافة إلى هذه الميزات ، فإن آلية الوعي الذاتي متعددة الرؤوس المستخدمة في GPT تكرر العملية عدة مرات بدلاً من التحقق من أهمية الكلمات مرة واحدة ، مما يجعل النموذج قادرًا على فهم المفاهيم الفرعية والعلاقات الأكثر تعقيدًا لبيانات الإدخال.

مشاكل وقيود GPT-3

على الرغم من أن GPT-3 أدخل تحسينات كبيرة في معالجة اللغة الطبيعية (اللغات المستخدمة للبشر) ، فقد شوهدت أيضًا المشكلات والقيود في هذا الإصدار المتقدم. على سبيل المثال ، يواجه GPT-3 صعوبة في فهم إرشادات المستخدمين بشكل صحيح ولا يمكنه مساعدتهم كما ينبغي. بالإضافة إلى ذلك ، تنشر GPT-3 معلومات وبيانات غير صحيحة أو غير موجودة.

نقطة أخرى مهمة هي أن النموذج المذكور لا يمكنه تقديم تفسيرات مناسبة حول أدائه ولا يعرف المستخدمون كيف توصل GPT-3 إلى استنتاجات وقرارات. لا يحتوي الإصدار الثالث أيضًا على عوامل تصفية مناسبة وقد ينشر محتوى مسيئًا أو مؤذًا. هذه هي المشكلات التي حاولت OpenAI إصلاحها في الإصدارات التالية.

ChatGPT ومراحل تكوينه

من أجل حل مشاكل GPT-3 وتحسين الأداء العام لـ LLMs القياسية ، قدمت OpenAI نموذج لغة InstructGPT ، والذي أصبح فيما بعد ChatGPT.

شهدت InstructGPT تحسينات هائلة مقارنة بنماذج OpenAI السابقة ، وأسفر نهجها الجديد في استخدام التعليقات البشرية في عملية التدريب عن مخرجات أفضل بكثير. تسمى طريقة التدريس هذه بنموذج التعلم المعزز للتغذية الراجعة البشرية (RLHF) ، والذي يلعب دورًا مهمًا في فهم أهداف وتوقعات البشر عند الإجابة على الأسئلة.

يتضمن إنشاء هذا النموذج التعليمي وتطوير ChatGPT بواسطة OpenAI ثلاث خطوات عامة ، سنشرحها أدناه.

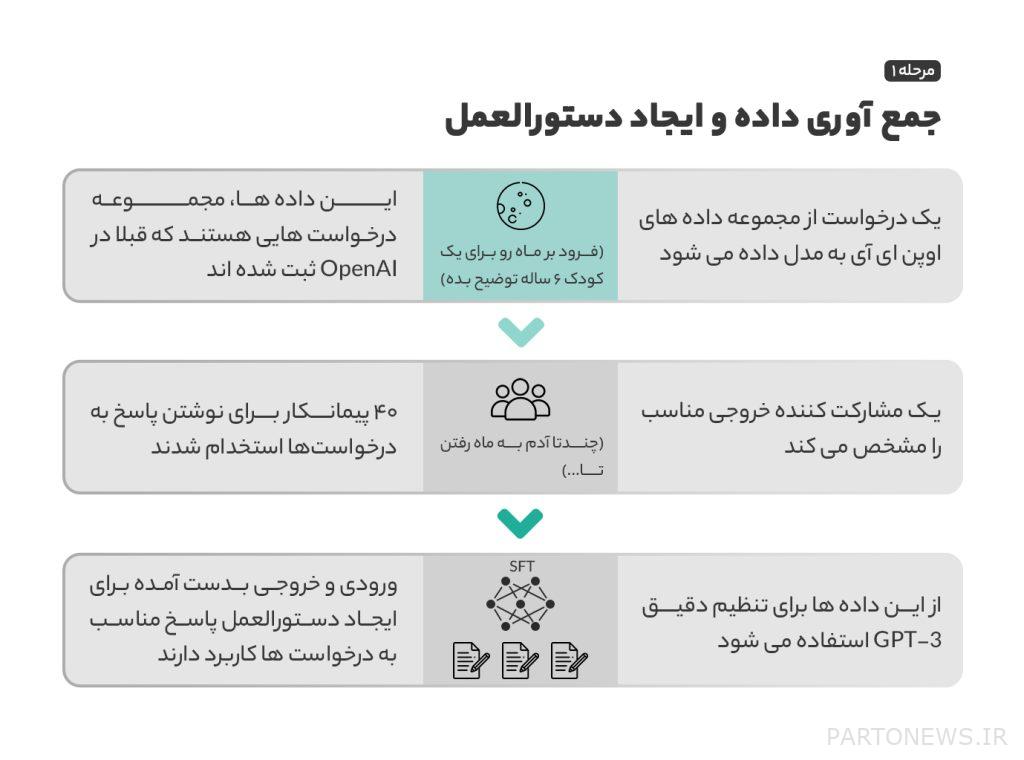

الخطوة 1: نموذج الضبط الدقيق الخاضع للإشراف (SFT)

في المراحل الأولى من التطوير ، لتحسين GPT-3 ، استأجرت OpenAI أربعين مقاولًا لإنشاء مجموعات بيانات تدريب خاضعة للإشراف للتعلم النموذجي. تم جمع بيانات الإدخال والطلبات هذه من مستخدمين حقيقيين وبيانات مسجلة في OpenAI. مع مجموعة البيانات هذه ، تم تطوير GPT-3.5 ، المعروف أيضًا باسم نموذج SFT.

حاول فريق OpenAI زيادة تنوع مجموعة البيانات إلى أقصى حد ، كما تمت إزالة جميع البيانات التي تحتوي على معلومات التعريف الشخصية من هذه البيانات. بعد جمع الطلبات والبيانات ، طلبت OpenAI من المشاركين تحديد وتصنيف كيفية طلب المستخدمين وطرح الأسئلة. نتيجة لهذا التحقيق ، تم تحديد ثلاث طرق رئيسية لطلب المعلومات:

- الطلبات التي يتم طلبها مباشرة ؛ على سبيل المثال ، “اشرح لي عن موضوع ما”.

- طلبات Fuschat الأكثر تعقيدًا ؛ على سبيل المثال ، “بناءً على نموذجين من القصص التي أرسلتها ، اكتب قصة جديدة بنفس الموضوع.”

- استمرار الطلبات بمواصلة الأمر ؛ على سبيل المثال ، “أنهي هذه القصة حسب المقدمة”.

أخيرًا ، أدى جمع الأوامر المسجلة في قاعدة بيانات OpenAI والمكتوبة بخط اليد من قبل المشاركين إلى إنشاء 13 ألف عينة من المدخلات والمخرجات لاستخدامها في النموذج.

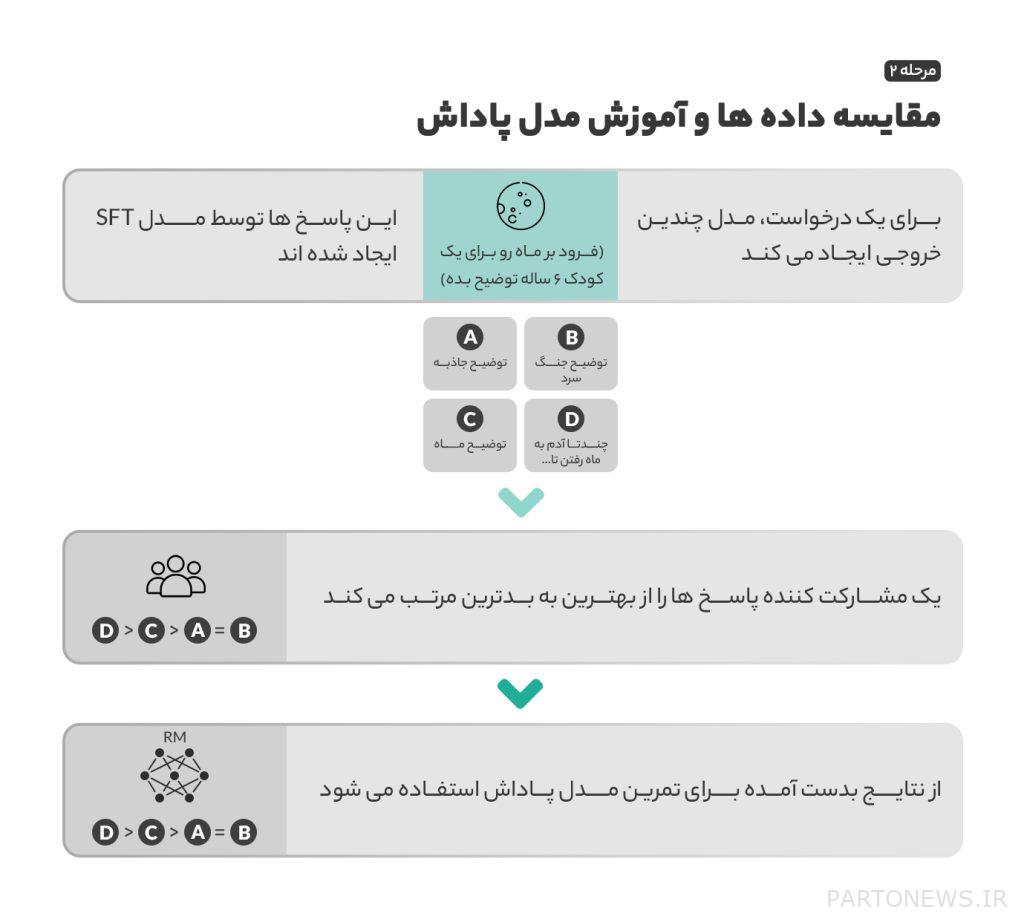

الخطوة 2: نموذج المكافأة

بعد تدريب SFT في الخطوة الأولى ، يتمتع النموذج بالقدرة على تقديم استجابات أكثر ملاءمة لطلبات المستخدم. ومع ذلك ، لا يزال هذا النموذج غير مكتمل ويحتاج إلى تحسين ؛ أصبح التحسين ممكنًا من خلال نموذج المكافأة والتعلم المعزز.

في هذه الطريقة ، يحاول النموذج العثور على أفضل نتيجة في مواقف مختلفة وإظهار أفضل أداء. في التعلم المعزز ، يُكافأ النموذج على اتخاذ الخيارات والأداء المناسبين ، ويُعاقب على اتخاذ خيارات وأداء غير مناسبين. في هذه المرحلة ، من خلال المكافآت والعقوبات ، يتعلم SFT إنشاء أفضل المخرجات بناءً على بيانات الإدخال.

لاستخدام التعلم المعزز ، نحتاج إلى نموذج مكافأة لتحديد المخرجات التي تتم مكافأتها وأي الردود يتم معاقبتهم. لتدريب نموذج المكافأة ، زودت OpenAI المشاركين بـ 4 إلى 9 مخرجات من نموذج SFT لكل بيانات إدخال وطلبت منهم ترتيب هذه المخرجات من الأفضل إلى الأسوأ. من خلال هذا التقييم ، تم إنشاء طريقة لقياس أداء SFT والتحسين المستمر.

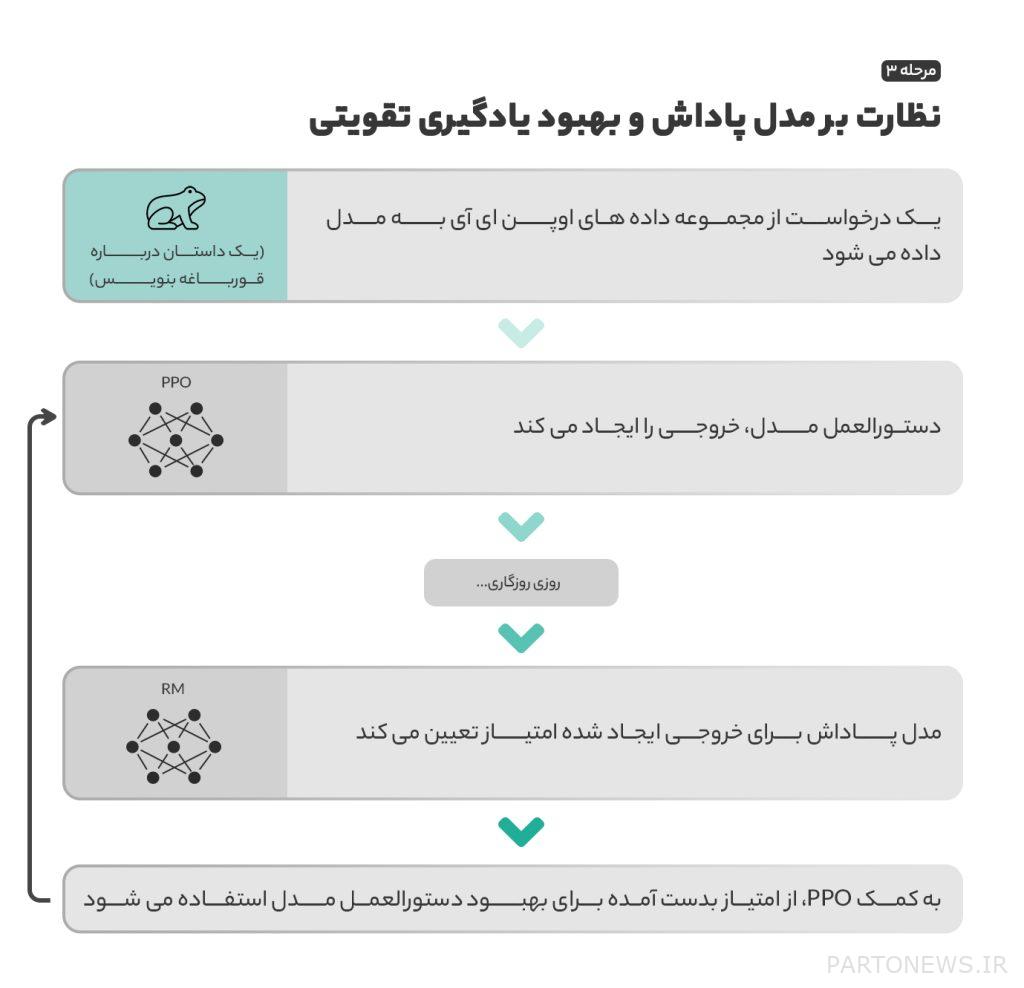

الخطوة 3: تعزيز نموذج التعلم

بعد إنشاء نموذج المكافأة ، في الخطوة الثالثة ، تم إعطاء مدخلات عشوائية للنموذج لمحاولة إنشاء مخرجات بأكبر قدر من المكافآت والنقاط. بناءً على نموذج المكافأة الذي تم تطويره في الخطوة الثانية ، تتم مراجعة الطلبات والمكافآت وترتيبها ، ثم يتم إرجاع النتائج التي تم الحصول عليها إلى النموذج لتحسين الأداء.

الطريقة المستخدمة لتحديث أداء النموذج حيث يتم إنشاء كل استجابة تسمى Proximal Policy Optimization (PPO) ، والتي تم تطويرها في عام 2017 من قبل المؤسس المشارك لـ OpenAI John Schulman وفريقه.

لدى PPO أيضًا عقوبة KL (KL) وهو أمر مهم جدًا في هذا النموذج. في التعلم المعزز ، يمكن للنموذج أحيانًا أن يتعلم التلاعب بنظام المكافآت الخاص به لتحقيق النتيجة المرجوة. يقود هذا النموذج إلى إنشاء بعض الأنماط التي ليس لها مخرجات جيدة على الرغم من حصولها على درجة أعلى.

لحل هذه المشكلة ، يتم استخدام عقوبة KL. هذه الميزة لا تجعلها معيارًا لإنشاء مخرجات بمزيد من النقاط فقط ولا يوجد فرق كبير مع الإخراج الذي تم إنشاؤه بواسطة SFT في الخطوة الأولى.

تقييم النموذج

بعد الانتهاء من الخطوات الرئيسية لبناء النموذج وتدريبه ، يتم إجراء سلسلة من الاختبارات أثناء التدريب لتحديد ما إذا كان النموذج الجديد يعمل بشكل أفضل من النموذج السابق. يتكون هذا التقييم من ثلاثة أجزاء.

أولاً ، يتم التحقق من الأداء العام وقدرة النموذج على فحص واتباع تعليمات المستخدم. وفقًا لنتائج التجارب ، فضل المشاركون مخرجات InstructGPT على GPT-3 بنسبة 85٪ تقريبًا من الوقت.

كان النموذج الجديد أكثر قدرة على توفير المعلومات ، وبمساعدة PPO ، شوهدت معلومات أكثر صحة ودقة في المخرجات. أخيرًا ، تم أيضًا التحقيق في قدرة InstructGPT على نشر أو منع المحتوى غير اللائق والمهين والمؤذي.

أظهرت الدراسات الاستقصائية أن النموذج الجديد يمكن أن يقلل بشكل كبير من المحتوى غير المناسب. ومن المثير للاهتمام ، أنه عندما طُلب من النموذج إرسال استجابات غير ملائمة عن عمد ، كانت المخرجات أكثر هجومًا بشكل ملحوظ من نموذج GPT-3.

بنهاية مرحلة التقييم ، سجل InstructGPT تحسينات كبيرة وأظهر أدائه على chatbot ChatGPT الشهير. إذا كان لديك المزيد من الأسئلة حول كيفية تطوير ChatGPT وعمله ، يمكنك ذلك مقالة رسمية تم نشره بواسطة OpenAI.