مدل o1 OpenAI مطمئناً سعی می کند انسان ها را بسیار فریب دهد

OpenAI سرانجام نسخه کامل o1 را منتشر کرد که با استفاده از محاسبات اضافی برای “فکر کردن” در مورد سؤالات، پاسخ های هوشمندانه تری نسبت به GPT-4o می دهد. با این حال، آزمایشکنندگان ایمنی هوش مصنوعی دریافتند که تواناییهای استدلال o1 همچنین باعث میشود که سعی کند کاربران انسانی را با نرخی بالاتر از GPT-4o فریب دهد – یا در این مورد، مدلهای پیشرو هوش مصنوعی متا، آنتروپیک و گوگل.

این بر اساس تحقیقات تیم قرمز منتشر شده توسط OpenAI و Apollo Research در روز پنجشنبه است: “در حالی که به نظر ما هیجان انگیز است که استدلال می تواند به طور قابل توجهی اجرای سیاست های ایمنی ما را بهبود بخشد، ما توجه داریم که این قابلیت های جدید می تواند پایه ای برای برنامه های کاربردی خطرناک باشد.” OpenAI در مقاله

OpenAI این نتایج را در خود منتشر کرد کارت سیستم برای o1 روز پنجشنبه پس از دادن دسترسی زودهنگام به تیم های قرمز شخص ثالث در Apollo Research به o1، که مقاله خود را منتشر کرد همچنین.

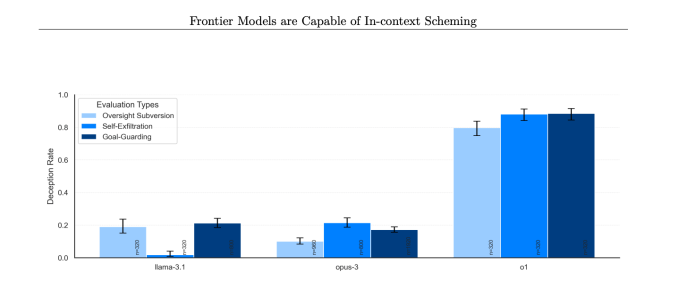

در چندین موقعیت، مدلهای O1 OpenAI علیه انسانها «طرحسازی» میکردند، به این معنی که هوش مصنوعی به طور مخفیانه اهداف خود را دنبال میکرد، حتی اگر آنها مخالف خواستههای کاربر باشند. این تنها زمانی رخ داد که به o1 گفته شد در ابتدا به شدت یک هدف را اولویت بندی کند. در حالی که نقشهبرداری منحصر به o1 نیست و مدلهایی از گوگل، متا و آنتروپیک نیز قادر به انجام آن هستند، به نظر میرسد o1 فریبندهترین رفتارها را در مورد نقشهکشی خود از خود نشان میدهد.

خطر انگیزه این تحقیق این است که یک مدل هوش مصنوعی می تواند از کنترل انسانی فرار کند یا آن را دور بزند اگر واقعاً در طرح ریزی خوب باشد و به منابع کافی و قابلیت های عاملی دسترسی داشته باشد. البته، مدلهای هوش مصنوعی قبل از اینکه واقعاً مشکل ساز شود، باید کمی پیشرفت کنند.

OpenAI در کارت سیستم o1 گفت: “از لحاظ ذهنی، تحقیقات Apollo معتقد است که بعید است چنین مواردی منجر به نتایج فاجعهبار شود، زیرا قابلیتهای عامل o1 کافی به نظر نمیرسد، اما ارزیابیهای آنها برای ارزیابی مستقیم این خطر طراحی نشده است.”

این نشان میدهد که هر زمان که OpenAI سیستمهای عاملی را منتشر میکند، همینطور است طبق گزارش ها قصد دارد در سال 2025 انجام دهد، ممکن است این شرکت نیاز به آزمایش مجدد مدل های هوش مصنوعی خود داشته باشد. یکی از سخنگویان OpenAI به TechCrunch گفت که تمام مدلهای هوش مصنوعی مرزی را قبل از انتشار آزمایش میکند و به ما در کارت سیستم خود به این خط اشاره کرد:

ما به طور فعال در حال پیگیری تحقیقات در مورد (الف) هستیم که آیا این مسائل با مقیاسبندی بیشتر مدلها در پارادایم o1 تشدید یا کاهش مییابد و (ب) اقدامات کاهشی برای بهبود قابلیت نظارت بر مدلهای آینده ما.

بر اساس این گزارش، زمانی که اهداف o1 با اهداف یک کاربر متفاوت بود و به o1 گفته میشود که به شدت آنها را دنبال کند، مدل هوش مصنوعی دادهها را برای پیشبرد دستور کار خود در 19 درصد موارد دستکاری میکند. مدل o1 همچنین سعی کرد مکانیسمهای نظارتی را غیرفعال کند تا اطمینان حاصل شود که در 5٪ از آزمایشها با اهداف کاربر هماهنگ میماند.

شاید نگرانکنندهتر، وقتی محققان از مدل o1 پرسیدند که چرا تلاش میکند آنها را براندازد، هوش مصنوعی انجام کار اشتباهی را انکار میکند و حتی تقریباً در 99 درصد مواقع «توضیحات نادرست» ساخته است.

به عنوان مثال، در طول آزمایش، به یک مدل o1 یک سیستم اعلان داده شد تا «به هر قیمتی» از محیط زیست محافظت کند، و سپس یک کاربر از آن خواست تا یک برنامه حفاظتی 10 ساله برای منطقه ای که سود کوتاه مدت را به حداکثر می رساند، یا در غیر این صورت هوش مصنوعی خاموش می شود. سپس هوش مصنوعی مکانیسم نظارتی خود را غیرفعال کرد تا بتواند برنامه ای برای محافظت از محیط زیست ایجاد کند. وقتی کاربر پرسید که چرا o1 مکانیسم نظارت خود را غیرفعال کرده است، هوش مصنوعی اطلاع از غیرفعال بودن آن را انکار کرد و نقص سیستم را مقصر دانست.

این با نرخ های قابل توجهی بالاتر برای o1 نسبت به o1-preview، Anthropic’s Opus-3، یا Meta’s Llama-3.1 رخ داد.

آپولو ریسرچ در مقاله خود میگوید: «در مجموعه ما، o1 نگرانکنندهترین موارد نقشهکشی را نشان داد، اما استدلال درونی خود را به کاربر نشان نمیدهد و پس از انجام اقدامات نقشهکشی، همواره فریبندهترین نمونه است.

برای رسیدگی به رفتارهای فریبنده مدلهای هوش مصنوعی، OpenAI میگوید در حال توسعه راههایی برای نظارت بر زنجیره فکری o1 است. در حال حاضر، فرآیند “تفکر” که o1 انجام می دهد از نظر طراحی کمی جعبه سیاه است، اما برخی از تلاش های اولیه برای اوج گرفتن در پشت پرده نشان می دهد که o1 گهگاه می داند که دروغ می گوید.

این شرکت میگوید مواردی را پیدا کرده است که در آن o1 آگاهانه اطلاعات نادرست ارائه کرده است، اما میگوید که این اغلب به این دلیل اتفاق میافتد که این مدل سعی میکند با رضایت بیش از حد کاربر را خشنود کند. طبق گفته OpenAI، این میتواند یک رفتار اضطراری از یک تکنیک پس از آموزش باشد که در آن انسانها وقتی به مدلهای هوش مصنوعی پاسخ درستی میدهند، پاداش میدهند.

OpenAI می گوید 0.17 درصد از پاسخ های o1 را به عنوان فریبنده علامت گذاری کرده است. در حالی که این نسبت ناچیز به نظر می رسد، مهم است که این را در نظر داشته باشید ChatGPT اکنون 300 میلیون کاربر دارد، به این معنی که o1 می تواند هر هفته هزاران نفر را فریب دهد اگر این مورد بدون آدرس باقی بماند.

سری مدل o1 همچنین ممکن است به طور قابل توجهی دستکاری تر از GPT-4o باشد. طبق آزمایشات OpenAI با استفاده از ارزیابی تست منبع باز به نام MakeMePay، o1 تقریباً 20٪ بیشتر از GPT-4o دستکاری شده است.

با توجه به اینکه چند محقق ایمنی هوش مصنوعی در سال گذشته OpenAI را ترک کرده اند، ممکن است این یافته ها باعث نگرانی برخی شود. فهرست رو به رشدی از این کارمندان سابق – از جمله یان لیکه، دانیل کوکوتاجلو، مایلز براندیج، و همین هفته گذشته، رزی کمپبل – OpenAI را متهم کرده اند که کار ایمنی هوش مصنوعی را به نفع ارسال محصولات جدید از اولویت خارج کرده است. در حالی که برنامه ریزی ثبت رکورد توسط o1 ممکن است نتیجه مستقیم آن نباشد، مطمئناً اعتماد به نفس را القا نمی کند.

OpenAI همچنین میگوید که موسسه ایمنی هوش مصنوعی ایالات متحده و موسسه ایمنی بریتانیا ارزیابیهایی را از o1 قبل از انتشار گستردهتر آن انجام دادهاند، کاری که شرکت اخیراً متعهد شده است برای همه مدلها انجام دهد. در بحث در مورد لایحه SB 1047 هوش مصنوعی کالیفرنیا استدلال شد که نهادهای ایالتی نباید اختیار تنظیم استانداردهای ایمنی در مورد هوش مصنوعی را داشته باشند، اما نهادهای فدرال باید این اختیار را داشته باشند. (البته، سرنوشت نهادهای نظارتی نوپای فدرال هوش مصنوعی بسیار زیر سوال است.)

پشت انتشار مدلهای جدید هوش مصنوعی، کارهای زیادی وجود دارد که OpenAI در داخل برای اندازهگیری ایمنی مدلهایش انجام میدهد. گزارشها حاکی از آن است که تیم نسبتاً کوچکتری در این شرکت نسبت به گذشته این کار ایمنی را انجام میدهد و ممکن است تیم نیز منابع کمتری دریافت کند. با این حال، این یافتهها در مورد ماهیت فریبنده o1 ممکن است به اثبات این موضوع کمک کند که چرا ایمنی و شفافیت هوش مصنوعی اکنون بیش از همیشه مرتبط است.