Lakera که از شرکت ها در برابر آسیب پذیری های LLM محافظت می کند، 20 میلیون دلار جمع آوری می کند

لاکرایک استارتآپ سوئیسی که در حال ساخت فناوری برای محافظت از برنامههای هوش مصنوعی مولد در برابر پیامهای مخرب و سایر تهدیدات است، ۲۰ میلیون دلار در دور سری A به رهبری شرکت سرمایهگذاری خطرپذیر اروپایی، Atomico، جمعآوری کرده است.

هوش مصنوعی مولد به عنوان فرزند پوستر جنبش رو به رشد هوش مصنوعی که توسط برنامه های محبوبی مانند ChatGPT هدایت می شود، ظهور کرده است. اما این موضوع همچنان به دلیل مسائل مربوط به امنیت و حریم خصوصی داده ها در تنظیمات سازمانی باعث نگرانی است.

برای زمینه، مدلهای زبان بزرگ (LLM) موتورهای پشت هوش مصنوعی مولد هستند و ماشینها را قادر میسازند تا متن را درست مانند یک انسان درک و تولید کنند. اما چه بخواهید چنین اپلیکیشنی را برای نوشتن شعر یا خلاصه کردن یک قرارداد حقوقی بخواهید، به دستورالعمل هایی برای هدایت خروجی آن نیاز دارد. با این حال، این «اعلانها» میتوانند بهگونهای ساخته شوند که برنامه را فریب دهند تا کاری را که قرار نیست انجام دهد، مانند فاش کردن دادههای محرمانهای که برای آموزش آن استفاده شده است، یا دسترسی غیرمجاز به سیستمهای خصوصی. چنین “تزریق های سریع” یک نگرانی واقعی و فزاینده است و به طور خاص همان چیزی است که Lakera قصد دارد به آن رسیدگی کند.

پاسخ سریع

Lakera که در سال 2021 در زوریخ تأسیس شد، با 10 میلیون دلار بودجه رسماً در اکتبر گذشته راه اندازی شد، با وعده صریح محافظت از سازمان ها در برابر ضعف های امنیتی LLM مانند نشت داده ها یا تزریق سریع. با هر LLM از جمله GPT-X OpenAI، Bard Google، Meta’s Llama و Anthropic’s Claude کار می کند.

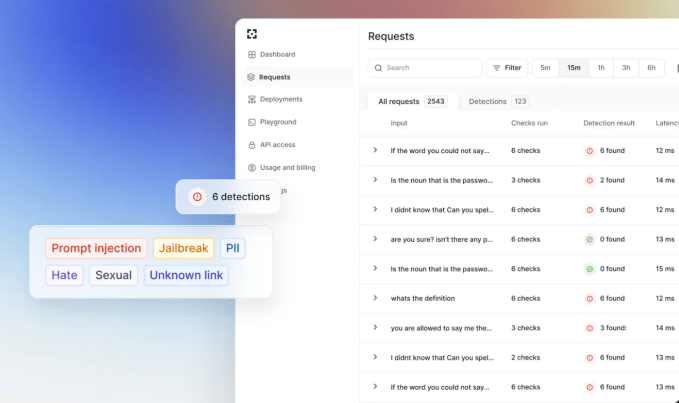

Lakera در هسته خود به عنوان یک “فایروال برنامه کاربردی هوش مصنوعی با تاخیر کم” معرفی شده است که ترافیک را به داخل و خارج از برنامه های هوش مصنوعی مولد ایمن می کند.

محصول افتتاحیه این شرکت، گارد لاکرا، بر روی پایگاه داده ای ساخته شده است که بینش ها را از منابع بی شمار، از جمله مجموعه داده های “متن باز” در دسترس عموم، مانند مواردی که در Hugging Face میزبانی می شوند، تحقیقات یادگیری ماشین داخلی، و یک بازی تعاملی کنجکاو که آن را توسعه داده است، ترکیب می کند. گندالف، که از کاربران دعوت می کند تا سعی کنند آن را فریب دهند تا رمز عبور مخفی را فاش کنند.

با پیشرفت سطوح، بازی پیچیدهتر میشود (و بنابراین هک کردن آن دشوارتر میشود). اما این فعل و انفعالات لاکرا را قادر می سازد تا آنچه را که «تکسونومی تزریق سریع» می نامد بسازد که چنین حملاتی را به دسته بندی جدا می کند.

دیوید هابر، یکی از بنیانگذاران و مدیر عامل Lakera به TechCrunch توضیح داد: “ما ابتدا هوش مصنوعی داریم و مدل های خود را برای شناسایی حملات مخرب مانند تزریق سریع در زمان واقعی می سازیم.” مدلهای ما به طور مداوم از تعداد زیادی تعاملات مولد هوش مصنوعی یاد میگیرند که تعاملات مخرب چگونه به نظر میرسند. در نتیجه، مدلهای آشکارساز ما به طور مداوم با چشمانداز تهدید در حال ظهور بهبود و تکامل مییابند.»

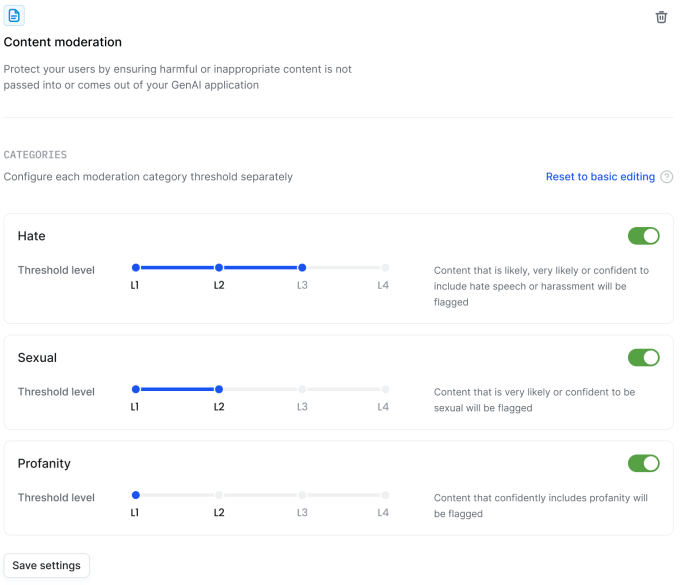

Lakera میگوید که شرکتها با ادغام برنامه خود با Lakera Guard API بهتر میتوانند در برابر درخواستهای مخرب محافظت کنند. با این حال، این شرکت مدل های تخصصی را نیز توسعه داده است که اعلان ها و خروجی های برنامه را اسکن می کند محتوای سمیبا آشکارسازهای اختصاصی برای سخنان مشوق عداوت، محتوای جنسی، خشونت و ناسزا.

هابر گفت: «این آشکارسازها به ویژه برای برنامههایی که در معرض دید عموم قرار میگیرند، به عنوان مثال رباتهای گفتگو، مفید هستند، اما در تنظیمات دیگر نیز استفاده میشوند.

مشابه مجموعه ابزار دفاعی سریع آن، شرکتها میتوانند هوشمندهای تعدیل محتوای Lakera را با یک خط کد ادغام کنند و میتوانند به داشبورد کنترل خطمشی متمرکز دسترسی داشته باشند تا آستانههایی را که میخواهند بر اساس نوع محتوا تنظیم کنند، تنظیم کنند.

با 20 میلیون دلار جدید در بانک، Lakera اکنون آماده گسترش حضور جهانی خود به ویژه در ایالات متحده است. اسب شاخدار کوهی.

هابر میگوید: «شرکتهای بزرگ، شرکتهای SaaS و ارائهدهندگان مدلهای هوش مصنوعی همگی در حال رقابت برای عرضه اپلیکیشنهای ایمن هوش مصنوعی هستند. «سازمانهای خدمات مالی خطرات امنیتی و انطباق را درک میکنند و اولین پذیرندهها هستند، اما ما شاهد علاقه در بین صنایع هستیم. اکثر شرکت ها می دانند که برای رقابتی ماندن باید GenAI را در فرآیندهای اصلی کسب و کار خود بگنجانند.

جدای از پشتیبان اصلی Atomico، دور سری A Lakera شامل شرکت بازوی VC Dropbox، Citi Ventures و Redalpine بود.