Runware از سخت افزار سفارشی و هماهنگ سازی پیشرفته برای استنتاج سریع هوش مصنوعی استفاده می کند

گاهی اوقات، یک نسخه نمایشی تنها چیزی است که برای درک یک محصول نیاز دارید. و این مورد در مورد Runware است. اگر سر به سمت وب سایت Runware، یک اعلان وارد کنید و برای تولید یک تصویر اینتر را فشار دهید، از اینکه Runware چقدر سریع تصویر را برای شما تولید می کند شگفت زده خواهید شد – کمتر از یک ثانیه طول می کشد.

Runware یک تازه وارد در استنباط AI یا AI مولد، چشم انداز راه اندازی است. این شرکت در حال ساخت سرورهای خود و بهینه سازی لایه نرم افزاری روی آن سرورها برای حذف تنگناها و بهبود سرعت استنتاج برای مدل های تولید تصویر است. این استارتآپ در حال حاضر ۳ میلیون دلار از طریق Speedrun از Andreessen Horowitz، Halo II از LakeStar و Lunar Ventures تامین کرده است.

این شرکت نمی خواهد چرخ را دوباره اختراع کند. فقط میخواهد سریعتر بچرخد. در پشت صحنه، Runware سرورهای خود را با حداکثر تعداد ممکن GPU بر روی همان مادربرد تولید می کند. این سیستم خنک کننده سفارشی خود را دارد و مراکز داده خود را مدیریت می کند.

زمانی که صحبت از اجرای مدلهای هوش مصنوعی بر روی سرورهای خود میشود، Runware لایه هماهنگسازی را با بهینهسازی بایوس و سیستم عامل برای بهبود زمان شروع سرد بهینه کرده است. این الگوریتم های خود را توسعه داده است که بار کاری تداخل را تخصیص می دهد.

نسخه ی نمایشی به خودی خود چشمگیر است. حالا این شرکت می خواهد از همه این کارها در تحقیق و توسعه استفاده کند و آن را به یک تجارت تبدیل کند.

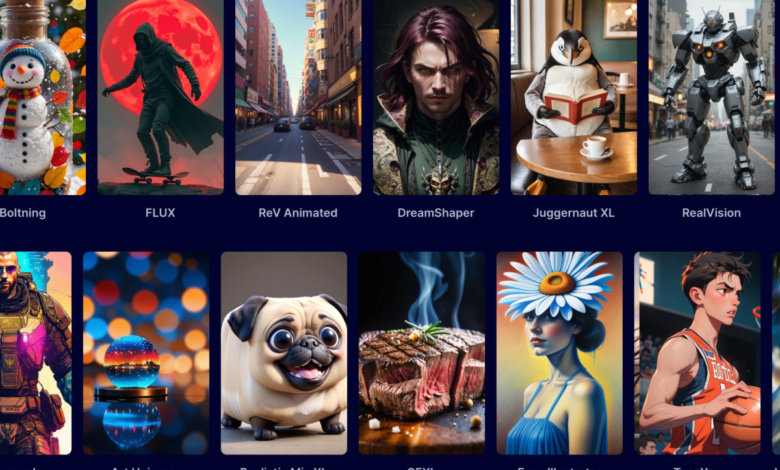

برخلاف بسیاری از شرکتهای میزبان پردازنده گرافیکی، Runware قرار نیست پردازندههای گرافیکی خود را بر اساس زمان GPU اجاره کند. در عوض، معتقد است که شرکت ها باید تشویق شوند تا حجم کاری را سرعت بخشند. به همین دلیل است که Runware یک API تولید تصویر با ساختار هزینه هزینه هر تماس API سنتی ارائه می دهد. این مبتنی بر مدلهای محبوب هوش مصنوعی از Flux و Stable Diffusion است.

فلاویو رادولسکو، یکی از بنیانگذاران و مدیر عامل شرکت، به TechCrunch گفت: «اگر به هوش مصنوعی، Replicate، Hugging Face – همه آنها نگاه کنید – محاسبات را بر اساس زمان GPU می فروشند. “اگر مدت زمانی را که برای ساختن یک تصویر طول می کشد با آنها مقایسه کنید. و سپس قیمت ها را مقایسه کنید، خواهید دید که ما بسیار ارزان تر، بسیار سریع تر هستیم.

او افزود: “برای آنها غیرممکن است که با این عملکرد مطابقت داشته باشند.” “به خصوص در یک ارائه دهنده ابر، شما باید در یک محیط مجازی اجرا کنید، که تاخیرهای اضافی را اضافه می کند.”

از آنجایی که Runware در حال بررسی کل خط لوله استنتاج و بهینه سازی سخت افزار و نرم افزار است، این شرکت امیدوار است که بتواند در آینده نزدیک از GPU های چندین فروشنده استفاده کند. این یک تلاش مهم برای چندین استارتاپ بوده است، زیرا انویدیا پیشرو آشکار در فضای GPU است، به این معنی که GPU های Nvidia بسیار گران هستند.

«در حال حاضر، ما فقط از پردازندههای گرافیکی Nvidia استفاده میکنیم. اما این باید انتزاعی از لایه نرم افزار باشد. ما میتوانیم یک مدل را از حافظه GPU خیلی سریع به داخل و خارج کنیم، که به ما امکان میدهد چندین مشتری را روی یک پردازنده گرافیکی قرار دهیم.

بنابراین ما مانند رقبای خود نیستیم. آنها فقط یک مدل را در GPU بارگذاری می کنند و سپس GPU نوع بسیار خاصی از کار را انجام می دهد. در مورد ما، ما این راهحل نرمافزاری را توسعه دادهایم که به ما امکان میدهد در حین استنتاج یک مدل را در حافظه GPU تغییر دهیم.»

اگر AMD و سایر فروشندگان GPU بتوانند لایههای سازگاری ایجاد کنند که با حجمهای کاری معمولی هوش مصنوعی کار میکنند، Runware به خوبی برای ساخت یک ابر ترکیبی که به پردازندههای گرافیکی چندین فروشنده متکی است، قرار میگیرد. و اگر بخواهد در استنتاج هوش مصنوعی ارزان تر از رقبا باقی بماند، مطمئناً کمک خواهد کرد.